6月27日,飞星火大模型V4.0及相关落地应用。该公司董事长刘庆峰表示,飞星火V4.0已经实现了与GPT-4 Turbo的对标,在文本生成、语言理解、知识问答、逻辑推理、数学等能力上都已经实现超越,但在代码和多模态能力上还有差距。

在刘庆峰看来,在推动源头智能体开发到行业生态的过程中,特别重要的是,一定要做到底座技术的完全自主可控,“否则可能我们就把大楼建在别人的院子里,建在沙滩上,随时会倒塌,要真正做到软硬件一体化,才能更深度地落地。”

图源:观察者网“去年10月17日,英伟达因为美国商务部的要求,对中国所有能训练大模型的智能算力全面断供。就在6月25日,OpenAI也正式通知将从7月9日开始终止所有来自中国的API申请。在这个背景下,热热闹闹、风起云涌的通用人工智能浪潮,到底有没有自主可控的国产底座能力做支撑,这决定了我们在这条路上到底能走多远。”刘庆峰说道。

他在会上透露,去年10月24日,飞联合华为在安徽发布了中国首个国产万卡算力集群,这是中国第一个能训千亿以上浮点参数大模型的硬件平台。在这个硬件平台上,飞星火是中国第一个基于国产算力训练出来的全民开放的大模型。

万卡集群,是指由一万张及以上的计算加速卡组成的集群式的高性能计算系统,主要用来训练数据量日益庞大的通用大模型。这种集群充分整合高性能GPU计算、高性能存储以及网络、智算平台等关键技术,可支持千亿级甚至万亿级参数规模的大模型训练,有助于大幅压缩训练时间,以实现模型能力的快速迭代升级。

那么在这个基础上,飞星火V4.0到底到了什么水平?刘庆峰表示,飞星火V4.0在中文领域实现了对标GPT-4 Turbo,在绝大部分是英文的12项主流测试集中,飞星火V4.0有8项实现了超越,“这个数据大家可以直接调用我们的API自己去测。”

但他也提到,星火大模型V4.0与GPT-4 Turbo在代码和多模态能力上还有差距。“今年1月,GPT-4 Turbo程序员测试大概在80分,现在86分,也在快速迭代和进步。我们预计在今年8月份,飞星火会达到现在86分以上的水平。多模态能力还有所差距,是因为我们当前在文生视频上还没有算力,也不是下一步的核心重点,但是有生态伙伴一起做。”刘庆峰说道。

去年9月,OpenAI发布GPT-4V,在图文识别和理解分析能力方面上了一个大台阶,11月推出语音识别大模型Whisper,今年2月又推出了文生视频大模型Sora,5月推出GPT-4o……

在刘庆峰看来。这些实际上还是依托GPT-4的底层通用大模型能力,“以Sora为例,并不是外界所说的其‘对物理世界的认知进一步加强了’,而是通过GPT-4V的理解能力和生成能力,结合GPT-4V的‘打标签’能力、传统的文生视频能力,用GPT方法做了重写,从而实现了Sora的能力。与大模型在医疗领域做一个医疗专用模型、在教育领域做一个教育专用模型并没有本质差别,只要有算力、有数据,这些都能实现。”

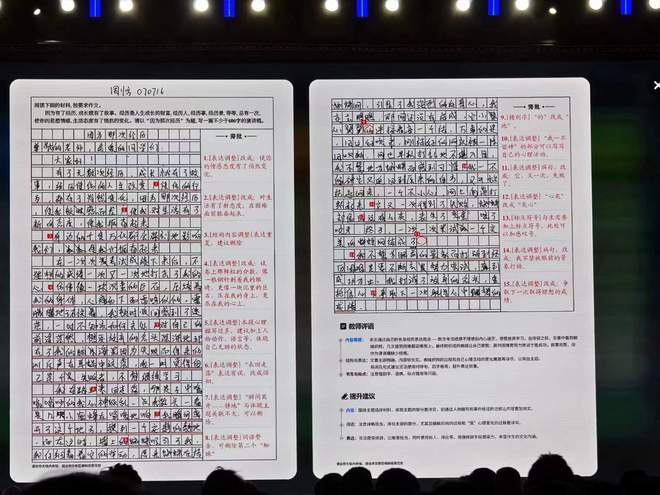

这次基于星火大模型能力,飞星火APP/Desk全新升级,发布“个人空间”;面向专业领域的个性化应用,飞晓医APP,上线个人数字健康空间;业界首发星火智能批阅机,“AI助教”助力老师减负增效、因材施教;飞AI学习机升级 1对1答疑辅导功能。

面向万物互联时代,飞星火语音大模型发布74个语种/方言免切换对话,破解强干扰场景下语音识别难题,发布国际领先的极复杂场景语音转写技术等,此外该公司还正式发布星火企业智能体平台,并推出星火商机助手、星火评标助手等典型智能体案例。

但值得注意的是,星火大模型V4.0对标的GPT-4 Turbo发布于去年11月,距今已近9个月。

刘庆峰也坦言,我们一定要科学理性地认识到中美科技的综合差距。“飞星火V4.0对标GPT-4 turbo是全方位对标。但是我们同时要看到,一旦GPT-5发布,因为它的模型尺寸更大、训练时间更长、数据更多,又会把这个差距给拉开,甚至拉到一年以上。”“在中国,一定要考虑用更小的算力、更小的数据,做出更优质的落地成果,这样才能够真正地在未来几年打赢这一场人工智能红利赋能产业的‘仗’,但同时,整个社会还要加强源头技术创新的氛围,一定要看到中美之间的差距,才能够迎头赶上,绝不能盲目自信,盲目地认为我们都已经超越了。差距还是很大的,需要大家有充分清晰而又理性地认知。 ”他表示。

刘庆峰直言,“今天人工智能技术的发展绝不是一家公司可以把所有事情都做完的,在这个时代,做帝国注定要衰落,只有生态才能生生不息;必须是自主可控的繁荣生态,才有中国通用人工智能大未来,我们要打造新的生态,包括源头技术生态、应用生态还有行业生态。”“我们既要认识到差距,又要有充分的信心,要能够科学理性地给出从源头技术、到生态、到产业应用落地的一整套打法,要以长期主义来打造真正自主可控的AI产业生态。”他说道。

根据大会信息,从今年1月30飞星火V3.5发布以来,大模型开发者团队目前已经增长到702万,海外开发者数量从34万增加到40万,大模型的直接相关开发者达到了57万。